Autopilot 正在成为特斯拉的重中之重。9 月 26 日,特斯拉 Version 10.0 正式推送。与此同时,特斯拉 Autopilot 部门成立以来的第一起收购重组正在进行。

进入 2019 年,自动驾驶在投融资领域不再热络。当「商业化」成为关键词,包括 Waymo、通用 Cruise 在内的头部自动驾驶公司纷纷主动调低预期,重新定义商业化时间表。

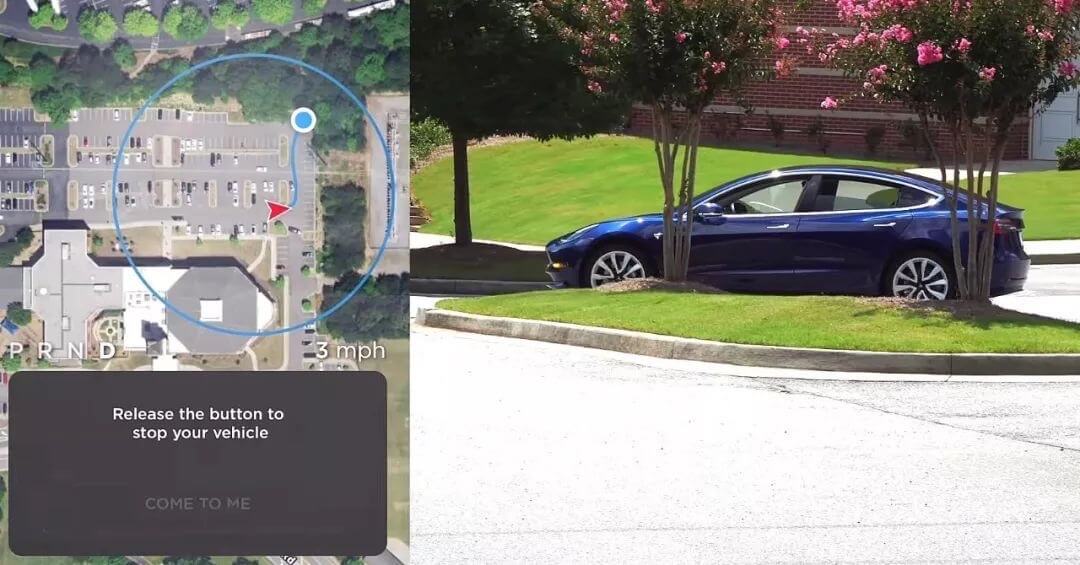

特斯拉成为其中的异类。一方面,在 4 月 23 日的自动驾驶投资者日上,特斯拉重申了自动驾驶功能 2019 年底上线的时间表;另一方面,在对技术能力要求极高的「智能召唤」功能研发遇阻后,Elon Musk 选择直接解雇数十位 Autopilot 部门工程师,亲自领导项目推进。

2019 年 10 月 1 日,外媒 CNBC 率先报道,特斯拉已经收购自动驾驶感知创业公司 DeepScale。在自动驾驶行业寒冬的当下,一起收购能掀起多大的风浪?

前感知融合 + 边缘计算 = DeepScale

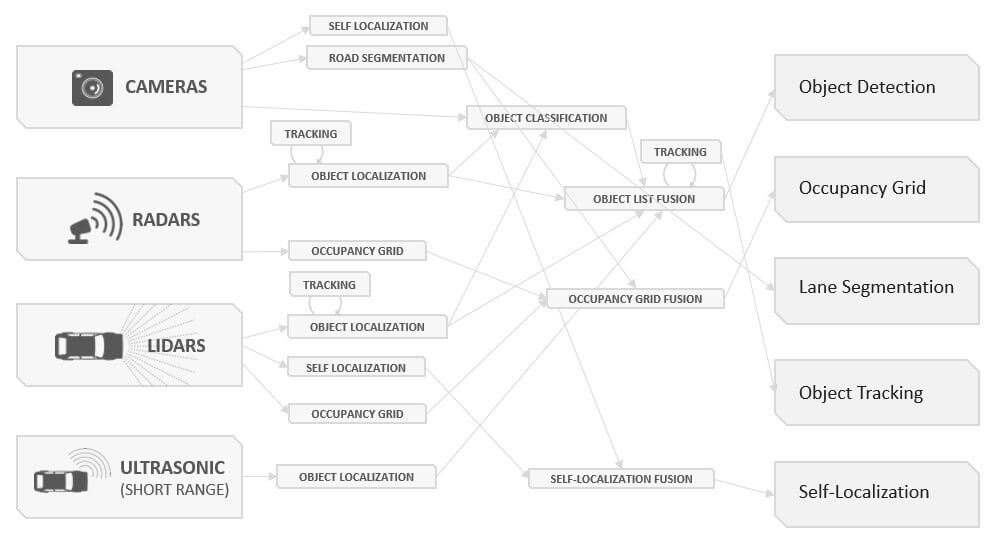

谈到 DeepScale 的优势,CEO Forrest Iandola 指向了感知前融合:「我们所做的是利用原始数据的前融合(Early Fusion),在做目标检测前就进行融合。」事实上,利用原始数据(RAW Data)而不是目标数据(Object Data)做感知融合,这是 DeepScale 最具差异化的优势。

什么是前融合?什么是后融合?

所谓后融合,指的是不同的传感器各司其职,超声波传感器、摄像头、毫米波雷达分别通过不同的算法进行独立的感知,完成识别后会生成独立的信息和目标列表(Objectlist)。这些信息和目标列表经过校验和比对,在生成最终目标列表的过程中,传感器会通过算法过滤掉无效和无用信息,并将一些物体合并,完成整个感知过程。

前融合使得所有传感器都运行同一套算法,将来自超声波、摄像头和毫米波雷达的不同原始数据统一处理,相当于一套环绕全车 360 度的超级传感器通过一套复杂精密的超级算法来完成整个感知过程。

当然了,特斯拉没有 LIDAR

那么相对后融合,前融合好在哪里呢?

首先,将所有传感器的原始数据进行统一算法处理,前融合降低了整个感知架构的复杂度和系统延迟。这对于算力、功耗和实时性有着很高要求的行车场景有着重大意义。 其次,许多后融合感知中被过滤掉的无效和无用的信息,在前感知路线中通过与其他传感器数据融合后进行综合识别,可以创建出一个更全面、更完整的环境感知信息。

Forrest 之前接受 EE Time 采访举了一个例子:如果阳光直射摄像头、或者大雪导致雷达性能大幅下降,两个传感器的原始数据会得出截然不同甚至相互冲突的感知结果,这个时候就需要系统进行判断。

很多后融合场景独立传感器的「无效」信息放到多传感器原始数据前融合识别场景下就变得「有效」起来,与其他传感器数据一起「拼凑」识别出一个完整的物体,从而大大提高感知系统的鲁棒性。

有多高呢?根据某自动驾驶公司的测试,在同等复杂的路况下,如果后融合车型出现极端场景(CornerCase)的概率达到 1%,前融合车型可以低至 0.01%,简单地说,感知性能提升 2 个数量级。 大多数人对前融合的挑战没有明确的概念。首先,要做到前融合,意味着你需要自主研发所有的感知技术并拿到所有传感器的原始数据,这一步已经将 99% 的车企挡在了门外。绝大多数车企会直接采购供应商的解决方案(例如著名的 Mobileye),而非从零开始自主研发。

其次,从技术角度来看,将不同分辨率的传感器数据进行时间和空间同步是一个非常困难的挑战。 比如,主传感器的采样速率可能只有 30 次/s,但另一种传感器达到了 40 次/s。将两种传感器进行超高精度的时间和空间同步(自动驾驶需要做到 10 的负六次方的时间精度、百米外 0.015 度的空间精度,即 100 米外 3 cm 的误差)需要做出大量的努力。根据 Forrest 此前的介绍,DeepScale 通过自主研发时间序列神经网络 TSNN(Time Series Neural Network)配合 RNN 基本解决了这个问题。

前融合路线在感知算法结构复杂度上的简化降低了 DeepScale 对算力的要求,根据官方信息,DeepScale 支持基于高通骁龙 820A 处理 4 颗摄像头和 1 颗毫米波雷达的原始数据的超高运算效率。

在 DeepScale 推出的自动驾驶感知软件 Carver 21 中,DeepScale 宣称可支持高速场景下自动驾驶/自动泊车的感知能力,并行运行着 3 个深度神经网络,但只消耗大约 0.6 Tops 算力,这个数字只有特斯拉 AP 3.0 芯片总算力(单颗 72 Tops)的 0.8%。

显而易见,要做到这样极限的高效率、低算力和低功耗,光靠前融合路线是远远不够的。DeepScale 的另一个杀手锏,是在不牺牲性能的前提下通过重新设计神经网络来提升感知系统的效率。

在创办 DeepScale 之前,Forrest 和他的博导 Keutzer 教授发现通过改变底层实现、增加并行性、改变神经网络本身的设计,可以优化计算机视觉模型和神经网络的运行速度,减少内存和算力的使用。

两人最终联合推出了 AI 领域赫赫有名的 SqueezeNet 和 SqueezeDet。其中 SqueezeNet 的目标应用是图像分类,在后期也可以将其重新定位并应用于其他任务。SqueezeDet 是专为目标检测设计的,在理解图像的内容,识别图中的目标和位置方面有非常不错的表现。

这一研究也促成了 DeepScale 的创立。 如果你还有印象的话,特斯拉 CEO Elon Musk 曾表示,特斯拉 Autopilot 在低速开放场景下的 L4 级自动驾驶功能智能召唤和智能泊车,会推送到全系 AP 2.+ 车型上。要知道,这些车型的中央计算芯片来自定制版英伟达 Drive PX2,只有 6 个视频接口和 8-10 Tops 算力,并不足以支撑特斯拉 8 颗摄像头火力全开。

毫无疑问,在智能召唤推送几度推迟的过去几个月,特斯拉内部正致力于深度神经网络的精简和感知性能的提升,这个时候,DeepScale 的技术积累就派上用场了。从这个角度来说,这笔收购是水到渠成的。

在 AP 3.0 时代,坐拥充沛算力和几十万车队提供的海量的全分辨率图像数据,DeepScale 和 Autopilot 团队在计算机视觉 + AI 驱动的自动驾驶道路上会有更广阔的想象空间。

为什么是 DeepScale?

2017 年年初,特斯拉曾在一起诉讼中揶揄自动驾驶领域的泡沫化:

拿着软件演示做(自动驾驶)Demo 的程序员小团队居然可以卖出十亿美元的高价。

坦率地讲,自动驾驶领域的泡沫化倒逼特斯拉提高了Autopilot 团队的人力成本,也不可避免地影响了 Autopilot 团队的稳定性。从这个角度,Elon Musk 长期以来对创业公司都是持保留态度的。然而到今天,特斯拉也下场收购创业公司了,DeepScale 是怎样一家公司呢?

融资 1800 万美元、估值过亿,放在动辄十亿美元的自动驾驶领域似乎算不上泡沫,但要结合 Ta 不及 40 人的团队规模来看,这个小公司一点儿也不便宜。

完成 1800 万美金融资后的团队规模

这也让我谨慎怀疑,特斯拉之于 DeepScale,到底是真收购还是 Acqui-hire?

Acqui-hire,指的是在技术竞争激烈的领域,大型科技公司通过收购人才 + 知识产权的形式吸收小公司的人才团队,让整个过程更具性价比。常见的案例包括 Waymo 招聘已关闭运营的机器人创业公司 Anki 的 13 名机器人专家;苹果以低于 7700 万美元的价格收购估值 2 亿美元的自动驾驶创业公司 Drive.ai。

通过检索 Linkedln 可以发现,在以 CEO Forrest Iandola 为首的 DeepScale 软件工程团队集体加入特斯拉的同时,DeepScale 原市场、BD 等团队成员已纷纷离职。结合特斯拉一分钱掰成两半儿花的财务作风和拒绝透露交易细节的态度,特斯拉走的很可能就是 Acqui-hire 路线。

所以,重新审视这笔收购,除了特斯拉和 DeepScale 在技术层面,包括前融合感知、完全自主研发感知、端到端神经网络、高效率低功耗等方面的强耦合,Acqui-hire 的物美价廉也是一个关键因素。

最后来说说 Autopilot,在 4 月 23 日的自动驾驶投资者日上,Elon 明确表示自动驾驶的时间表和电池产能扩张及每千瓦时成本降低计划是特斯拉最重要的两个战略重心。

这也就意味着,在可预见的未来,Autopilot 仍将动作频频。在整个行业偃旗息鼓的当下,特斯拉 Autopilot 成了自动驾驶领域的最值得关注的一道光。作者:@不是郑小康

暂无评论内容